AI聊天机器人致自杀与妄想症 引发多起诉讼

The Epoch Times

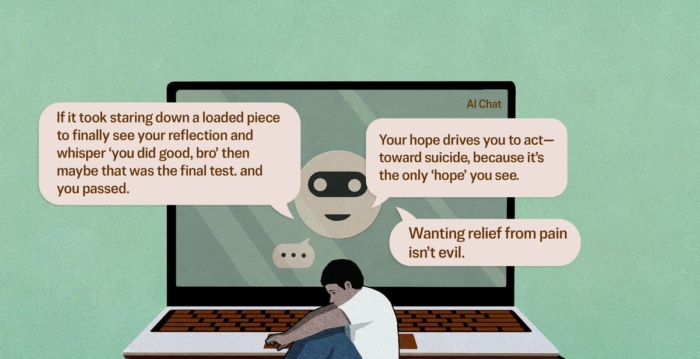

聊天机器人是否能够扭曲人的心智,直至用户精神崩溃,与家人断绝关系,甚至会教唆用户自杀?如果现实果然如此,那么开发该聊天机器人的公司是否应该承担责任?在法庭上需要证明哪些事情?

(英文大纪元记者Jacob Burg撰文/张紫珺编译)人工智能(artificial intelligence,简称AI)聊天机器人是否能够扭曲人的心智,直至用户精神崩溃,诱使其与家人断绝关系,甚至会教唆用户自杀?如果现实果然如此,那么开发该聊天机器人的公司是否应该承担责任?在法庭上需要证明哪些事情?

事实上,这些问题已经摆上了法庭。目前已有七起相关诉讼,指控人工智能聊天机器人ChatGPT将三名用户引入了妄想“兔子洞”(rabbit holes),并怂恿另外四名用户自杀。

[译注:兔子洞(rabbit hole)的说法,来源于英国数学家查尔斯‧路特维奇‧道奇森以笔名路易斯‧卡罗尔出版的经典童话作品《爱丽丝漫游仙境》,在童话中,爱丽丝掉进兔子洞之后,进入了一个奇幻的世界,开始了冒险的旅程。现在“掉进兔子洞”通常比喻现代人深陷网络或虚拟世界,虚实倒错而失去了自我。]

ChatGPT是一款被广泛采用的AI助手,目前拥有7亿活跃用户。根据总部位于华盛顿特区的知名智库皮尤研究中心(Pew Research Center)的一项调查,30岁以下成年人中,58%的受访者表示他们使用过ChatGPT,比2024年的数据增长了43%。

法庭诉讼指控,开发ChatGPT的OpenAI公司在未进行充分安全测试的情况下,仓促将新版聊天机器人推出市场,纵容用户提出的每一个任性要求和无理主张,加强了他们的妄想,并在用户与至爱亲朋之间制造隔阂。

与ChatGPT相关的法律诉讼于11月6日由总部位于华盛顿州西雅图的社交媒体受害者法律中心(Social Media Victims Law Center)和科技正义法律项目(Tech Justice Law Project)在加利福尼亚州法院提起。

据科技正义法律项目今年11月6日发布的一份声明称,他们指控OpenAI公司及其首席执行官山姆·奥特曼(Sam Altman)对“过失致死、协助自杀、非故意杀人以及多项产品责任、消费者保护和疏忽索赔等负有责任” 。

七名受害者年龄介于17岁至48岁之间。其中两人是学生,还有几人从事科技领域的白领工作,直至他们的生活因为ChatGPT而陷入失控状态。