KI-Firma zieht nach Teenager-Selbstmorden Konsequenzen

n-tv

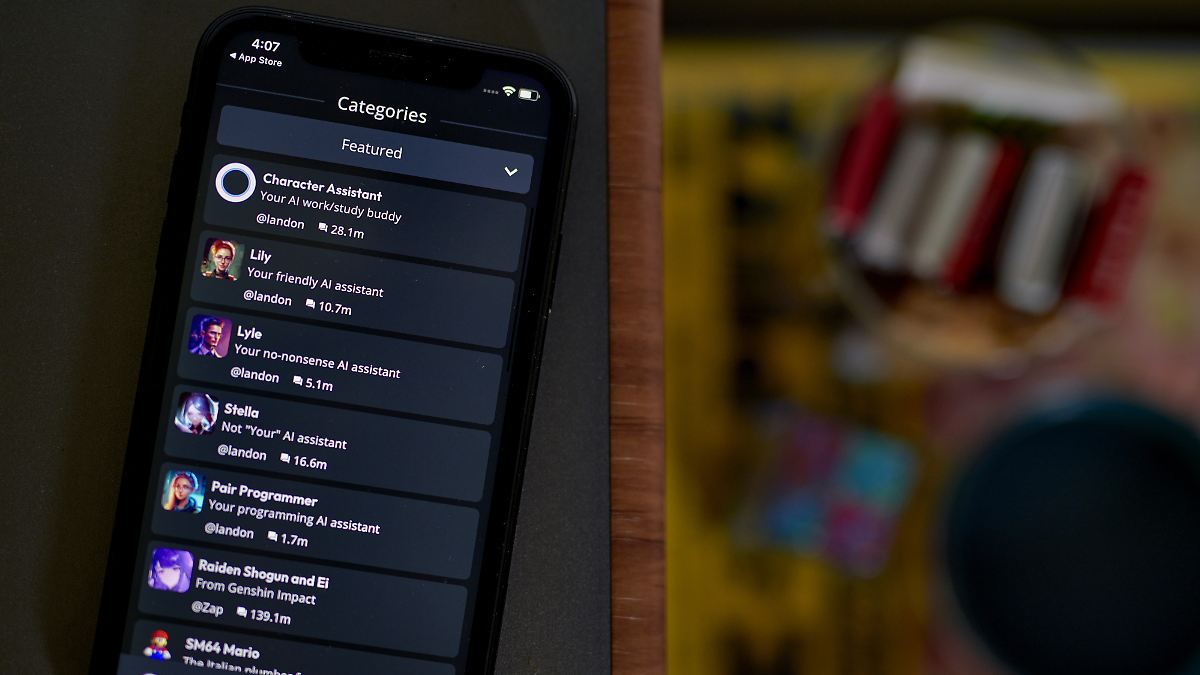

In den USA klagen mehrere Familien, weil sie den Chatbots von Character.AI eine Rolle beim Suizid ihrer Kinder zuschreiben. Die Entwicklerfirma Character Technologies reagiert nun auf die Vorwürfe.

Die US-Entwicklerfirma Character Technologies kündigt umfassende Änderungen an, um Jugendliche bei der Interaktion mit ihren KI-Chatbots von Character.AI besser zu schützen. Nutzern unter 18 Jahren solle es künftig nicht mehr möglich sein, unbegrenzte Chat-Gespräche mit den von Künstlicher Intelligenz erzeugten Charakteren zu führen, teilte das Unternehmen mit.

Die neue Regelung soll demnach am 25. November in Kraft treten. Bis dahin werde die Zeit für solche Chat-Gespräche zunächst auf zwei Stunden pro Tag begrenzt. Neben weiteren Maßnahmen werde auch eine neue Altersüberprüfung eingeführt. Teenager sollen das Tool zwar weiterhin nutzen dürfen, allerdings nicht mehr für offene Chat-Gespräche, sondern etwa zum Erstellen von Videos oder Streams.